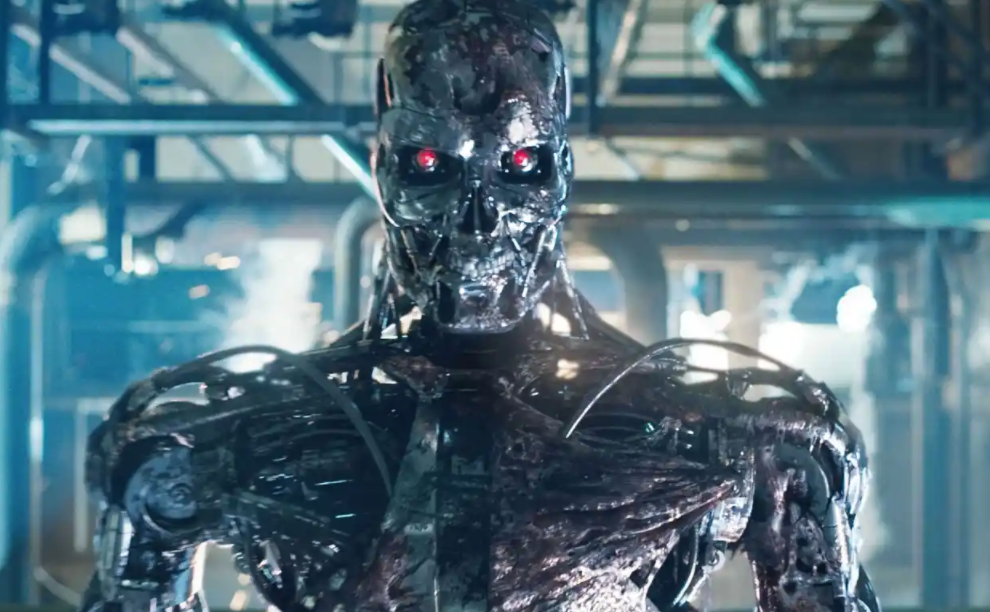

Les avancées de l’intelligence artificielle (IA) ouvrent de nouvelles possibilités dans le domaine militaire, pour la création de ce qu’on appelle des armes autonomes. Faut-il s’en inquiéter?

Faits à retenir

Les armes autonomes étaient d’ores et déjà une réalité avant l’IA.

L’ajout de l’IA leur procure une rapidité et une complexité accrues.

Cette complexité rend difficile, même pour leurs opérateurs humains, de prévoir le comportement de ces armes.

Qu’est-ce qu’un «système autonome»?

Un système est appelé «autonome» si, à partir du moment où il est activé, il fonctionne seul, sans intervention humaine.