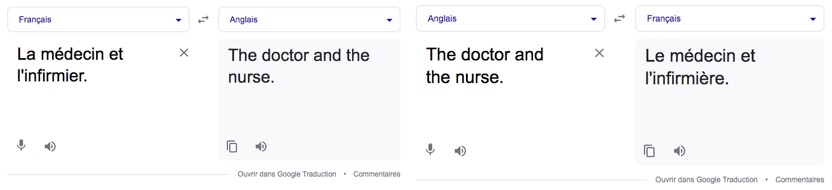

Des algorithmes d’intelligence artificielle peuvent-ils être sexistes et racistes? On a identifié plusieurs exemples qui favorisent effectivement la discrimination.

En 2014, Amazon a mis au point un logiciel pour analyser les CV des candidats à des postes dans leur entreprise. Le logiciel avait été entraîné grâce à une banque de données contenant le profil des employés embauchés ou promus sur une période de 10 ans.

En 2015, l’entreprise a toutefois découvert que le système avait une nette préférence pour les candidats masculins.

Voix et images

Une étude réalisée en 2017 par une chercheuse de l’Université de Washington a montré pour sa part que le logiciel de reconnaissance vocale de Google était moins efficace pour traiter les voix féminines. Selon l’auteure, cette différence pourrait s’expliquer par le fait que le logiciel serait moins performant pour analyser des voix aiguës.

En 2018, des chercheurs associés à Microsoft ont testé des applications utilisées pour analyser des images et déterminer le sexe de la personne. Ils ont remarqué que ces applications avaient un taux d’erreur très bas (0,8%) pour identifier les hommes blancs, mais de 34,7% pour les femmes noires.