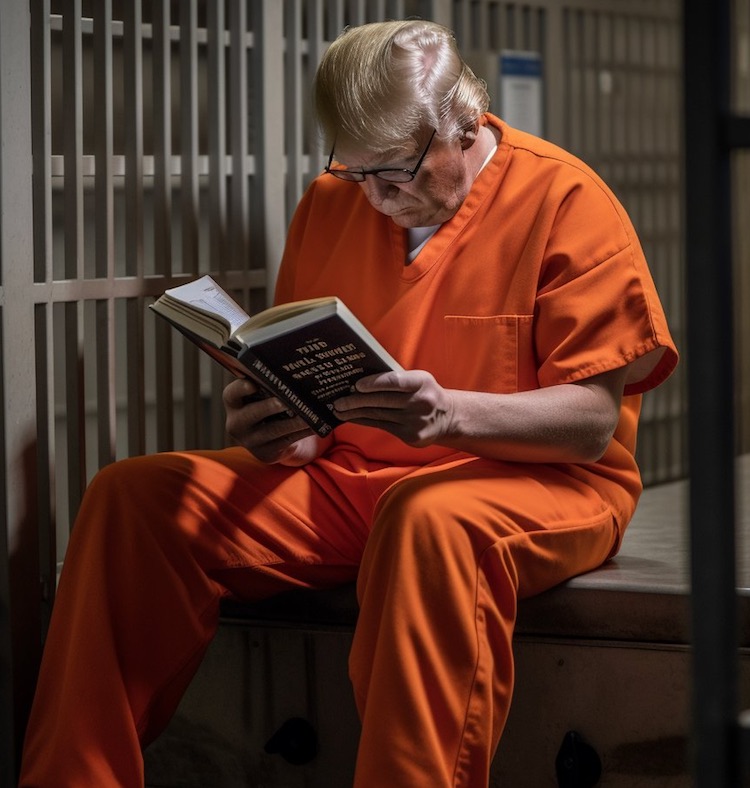

Le pape dans un manteau Balenciaga, Donald Trump en état d’arrestation, Emmanuel Macron dans un bain de boue… Les images créées par l’intelligence artificielle – fausses mais troublantes de réalisme – se sont multipliées ces dernières semaines. Pour l’instant, il est relativement facile de déterminer qu’il s’agit d’une fausse image. Mais l’IA va progresser.

Les réflexes de base continuent de s’appliquer

Pour commencer, les réflexes de base pour discerner le faux du vrai restent les mêmes: vérifier la source avant de partager une information — qu’il s’agisse d’un texte ou d’une image — et chercher une deuxième source si l’on a des doutes.

Ce sont ces mêmes réflexes sur lesquels on insiste depuis quelques années dans les formations de lutte contre la désinformation. Les avancées fulgurantes de l’intelligence artificielle (IA) montrent que l’acquisition de ces réflexes est encore plus importante qu’auparavant.

Vérifier la source… Qui est derrière le compte Facebook, Instagram, TikTok ou autre, de cette photo? Cette personne s’identifie-t-elle? A-t-elle un site web sur lequel on peut trouver une page «qui sommes-nous» (about us). Si cette photo a été publiée par un inconnu: méfiance.

Chercher une deuxième source… À l’évidence, si Donald Trump avait été arrêté ou si Emmanuel Macron s’était baigné dans la boue, quantité de médias en auraient parlé, en quelques minutes.